K8S-Back-off restarting failed container

K8S: Back-off restarting failed container

问题描述:

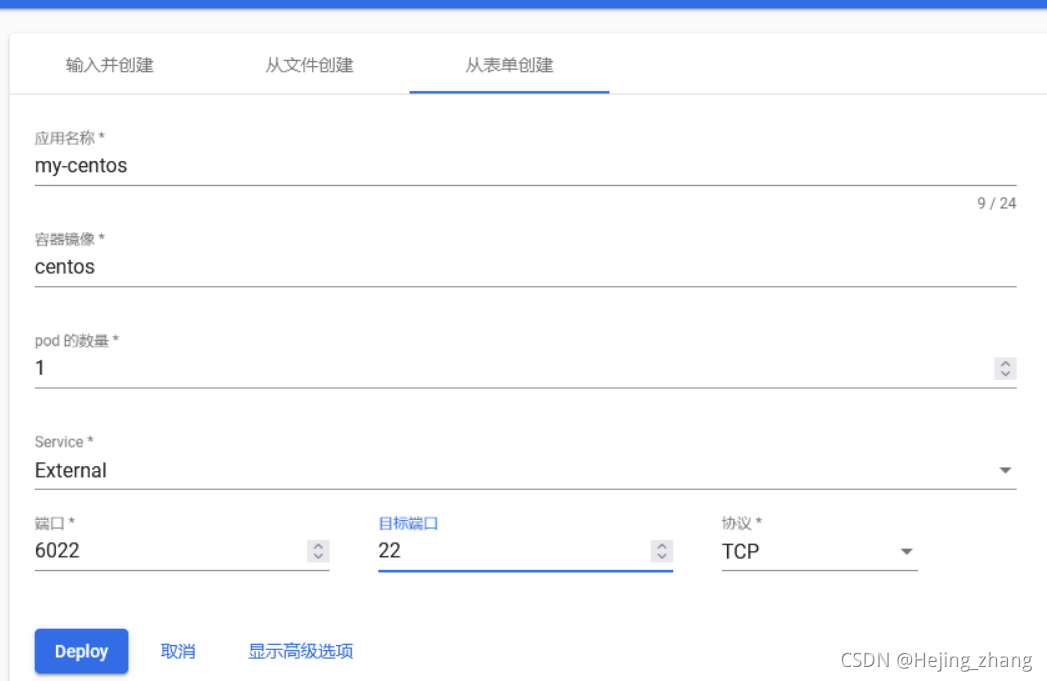

在网页k8s上想部署一个云主机,centos,于是乎:

1.创建资源-从表单创建

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Bh7XNhp3-1631347827522)(C:\Users\hejing\AppData\Roaming\Typora\typora-user-images\image-20210911150958616.png)]](https://images2.imgbox.com/3c/c1/Z8uLsbRw_o.png)

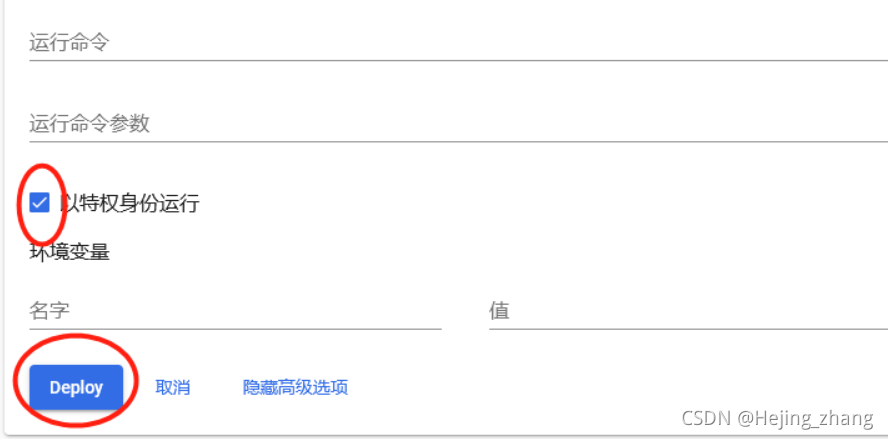

2.添加参数

3.以特权运行并部署

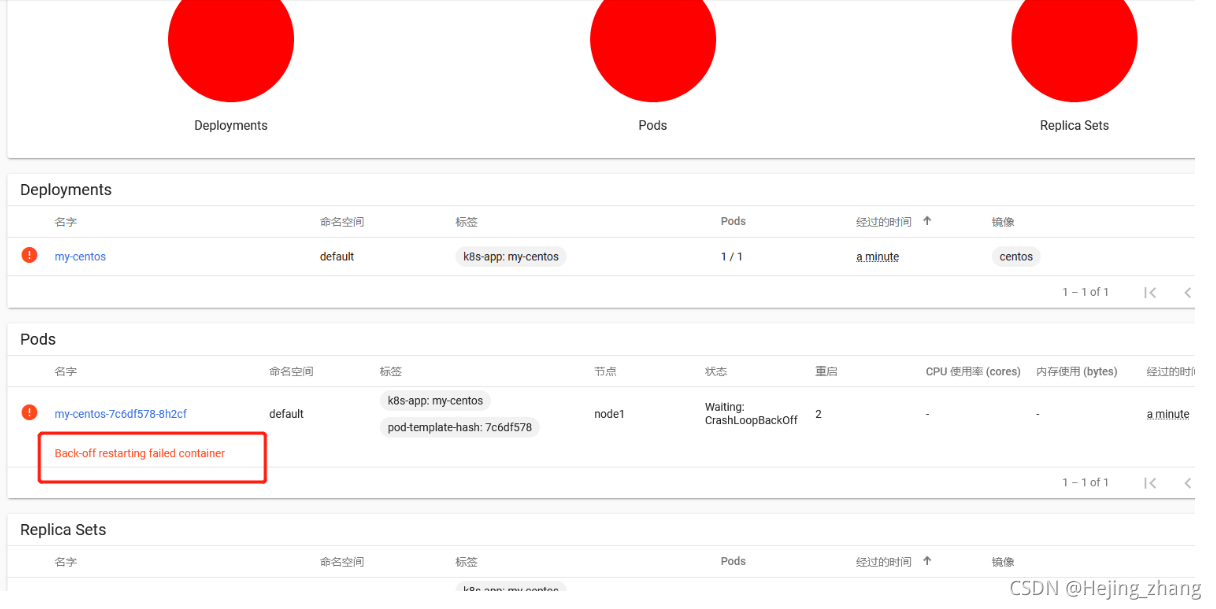

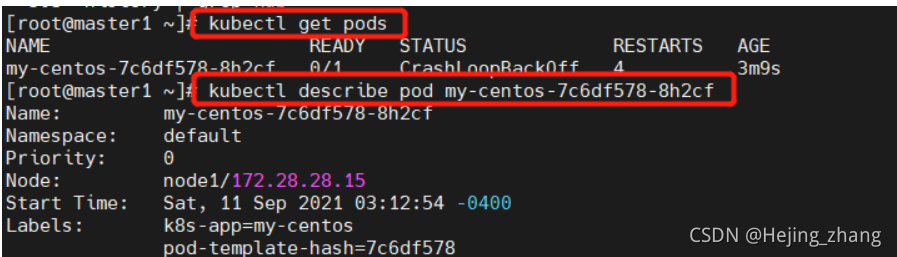

4.运行后最糟糕的三个红太阳出现了

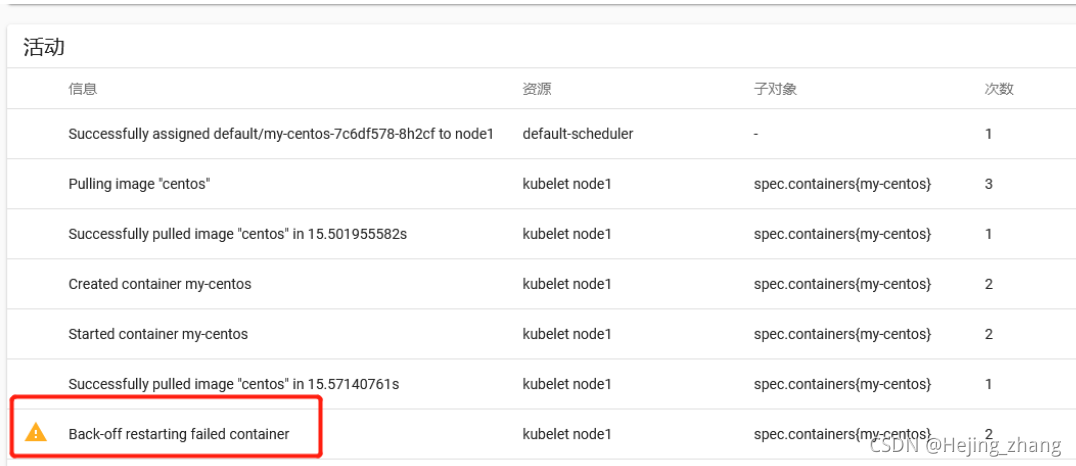

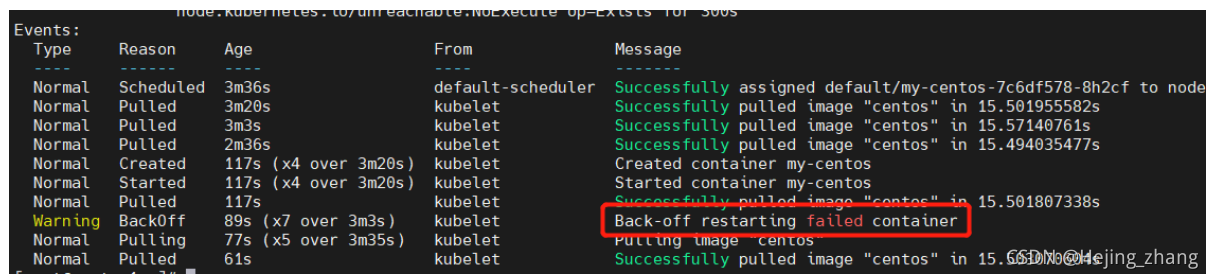

查看日志显示:

终端日志查看:重启失败

初学很懵逼,百度后解决:

原因:

我从官网pull的centos的image,启动容器后,容器内部没有常驻的前台进程,导致容器启动成功后就退出了,所以才一直重启restarting

类似系统级别的的容器,centos、Ubuntu、nginx都会这样

解决方法

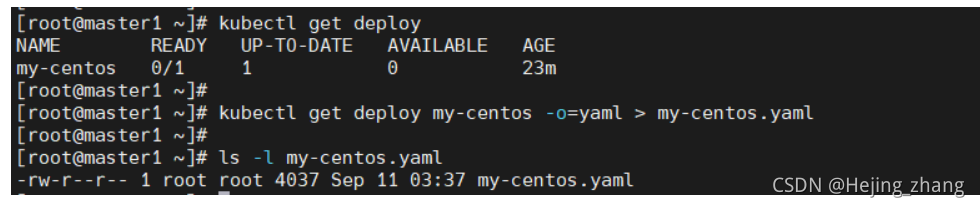

我是在网页上创建的pod资源,不知道对应的yam文件在终端哪里存着呢,所以先把yaml文件导出来,在删除pod,最后修改yaml文件并apply的。

# kubectl get deploy #查看deploy信息

# kubectl get deploy my-centos -o=yaml > my-centos.yaml #导出yaml文件修改

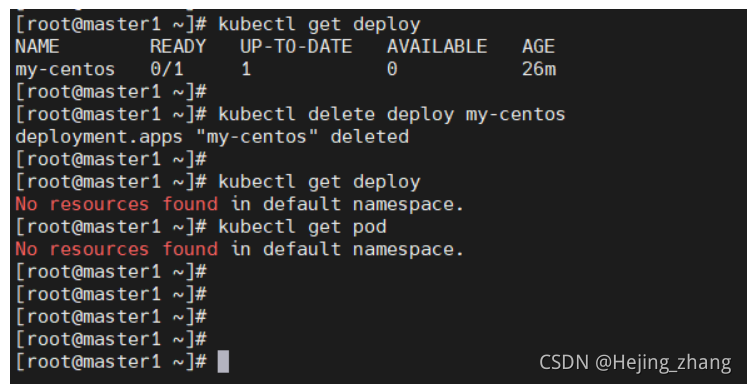

# kubectl get deploy

# kubectl delete deploy my-centos

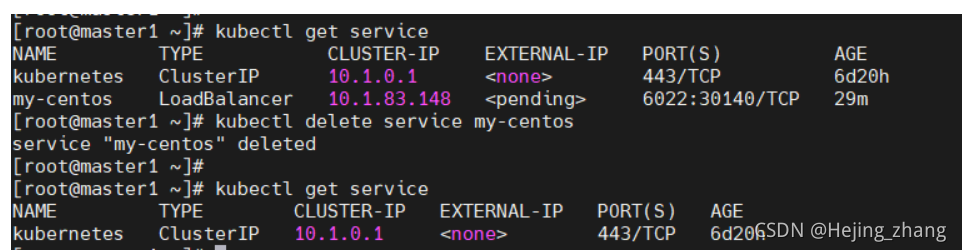

# kubectl get service

# kubectl delete service my-centos

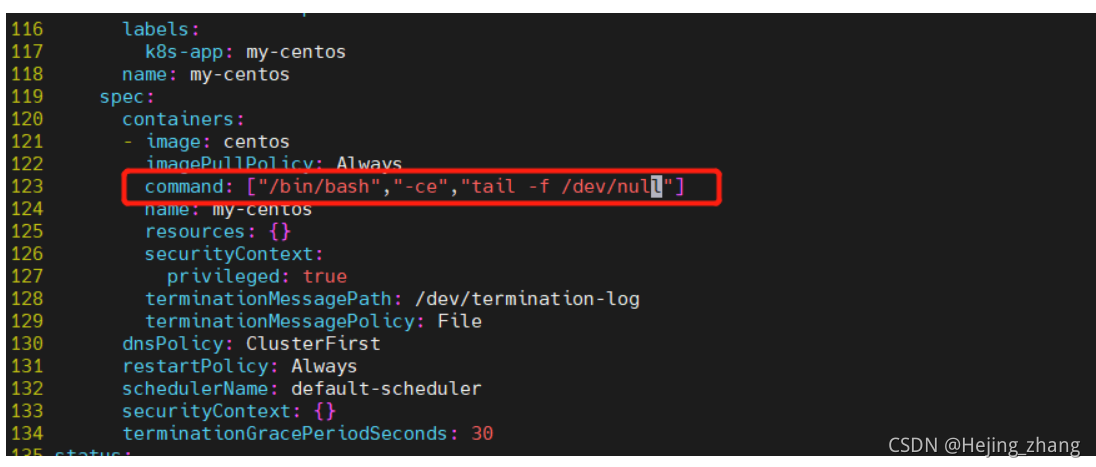

修改yaml文件,添加command:

command: ["/bin/bash","-ce","tail -f /dev/null"]

运行:

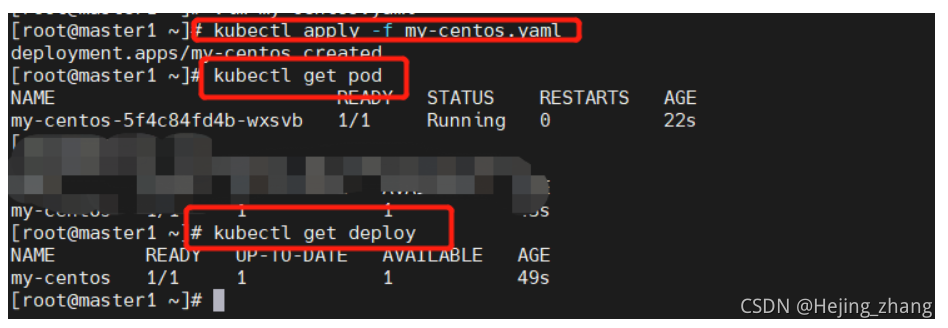

# kubectl apply -f my-centos.yaml

# kubectl get pod

# kubectl get deploy

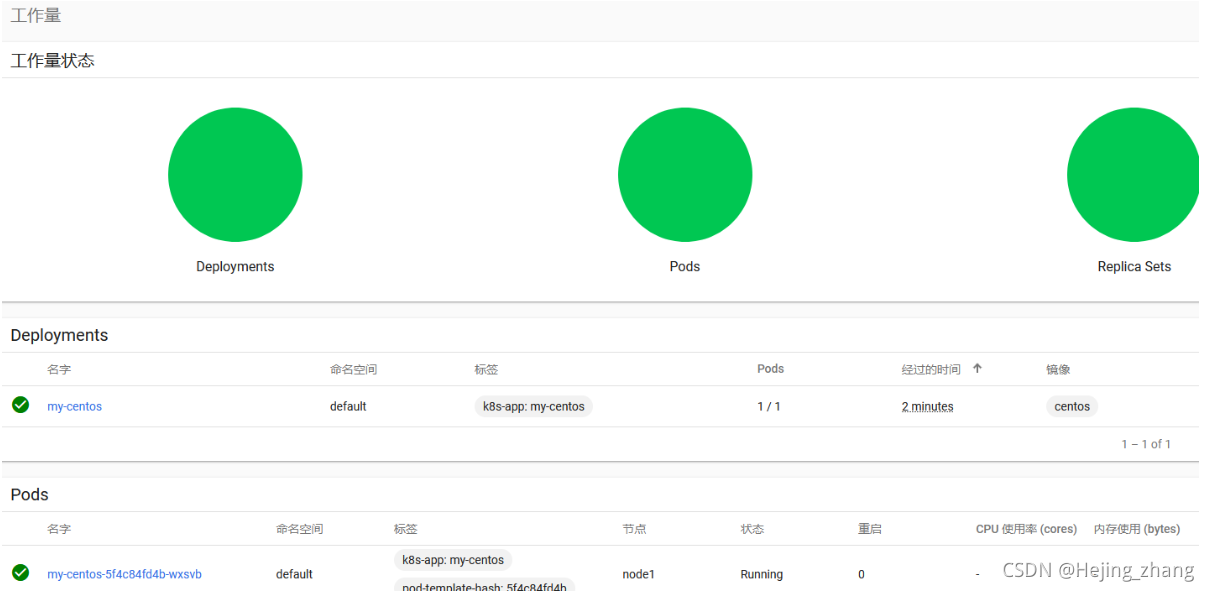

网页查看:

相当于直接在终端apply了,没有在网页上添加资源,继续搬砖。。。。。。