OpenAI暂停字节跳动账户:知识蒸馏技术是什么?

这一决策不仅成为了科技新闻的头条,更引发了关于AI伦理与法律的深入讨论。据报道,字节跳动涉嫌使用GPT数据来优化其自家AI模型。这一事件突显了在AI技术发展的道路上,遵循规则和伦理的重要性。

在这个背景下,知识蒸馏技术显得尤为重要。它不仅是AI技术的一个关键分支,更是在合规和伦理框架内推进技术创新的典范。知识蒸馏允许我们在保护原始数据隐私的前提下,转移和应用AI模型中的关键知识。这种技术使得即使在严格的数据使用规范和法律约束下,我们也能有效地利用AI模型的强大能力。

因此,本文将深入探讨知识蒸馏技术的原理、应用和挑战,同时着重强调其在遵守现代AI伦理和法律规范中的作用。我们将首先了解知识蒸馏的基本概念,然后探讨其在各种场景下的实际应用,最后讨论在技术发展和规则遵守并行不悖的大背景下,知识蒸馏如何成为连接理论与实践的重要桥梁。

文章目录

当前挑战

随着大规模机器学习和深度学习模型的应用日益广泛,我们面临着新的挑战。例如,GPT-3这样的模型在570GB的文本数据上进行训练,拥有高达1750亿个参数。虽然这些庞大的模型在推动技术发展方面发挥了重要作用,但将它们部署到实际应用中,尤其是边缘计算设备上,却是一项艰巨的任务。

数据科学的当前趋势主要集中在开发单一的大型模型或多模型组合,以在验证集上获得出色的表现。然而,这些验证集往往无法充分反映现实世界中的数据多样性。因此,尽管一些机器学习模型在精心策划的验证数据集上表现出色,但在实际应用中,面对真实测试数据时,它们往往难以满足性能、响应时间和处理能力的要求。

知识蒸馏技术

知识蒸馏技术为这些挑战提供了有效的解决方案。它通过从复杂的机器学习模型或多模型组合中提取关键知识,并将其转化为更小、更易于部署的单一模型,实现了在不显著降低性能的前提下应对这些挑战。这种方法不仅提高了模型的实用性,而且为深度学习的发展提供了新的视角。

博客内容概览

在本篇博客中,我将涵盖以下主题:

- 知识蒸馏的详细描述:包括其基本原理、训练方案和算法。

- 知识蒸馏在不同领域的应用:深入探索其在图像、文本和音频深度学习中的实际应用。

什么是知识蒸馏?

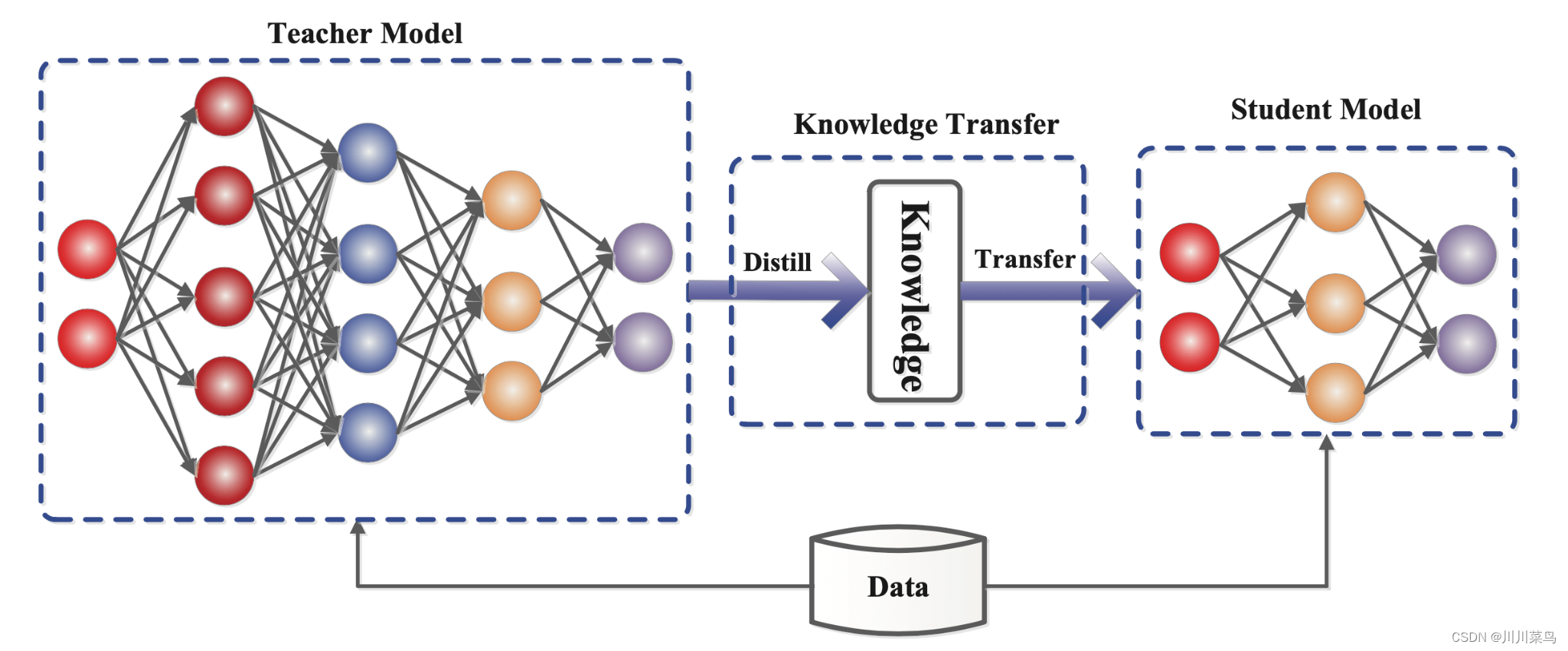

知识蒸馏指的是将知识从一个庞大、复杂的模型或一组模型传递到一个更小、更简洁的模型的过程。这种小型模型能够在现实世界的限制条件下得到有效部署。本质上,它是一种模型压缩的形式。

在过去十年中,随着深度学习在语音识别、图像识别和自然语言处理等领域的成功应用,知识蒸馏技术在现实世界应用中变得越来越重要。

特别是在部署大型深度神经网络模型时,面对内存和计算能力有限的边缘设备,这种挑战尤为显著。模型压缩方法的提出和希顿(Hinton)及其同事对“知识蒸馏”框架的正式命名,标志着这一技术的重要进步。

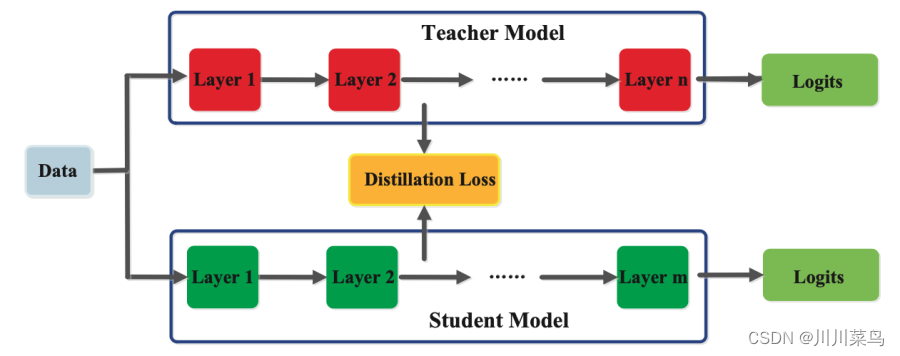

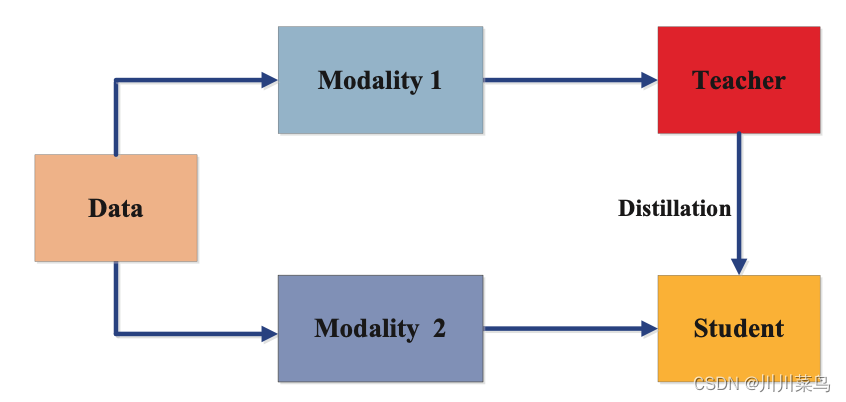

如图1所示,知识蒸馏中的小型“student”模型学习模仿大型的“teacher”模型,并利用教师的知识实现相似或更高的准确率。在接下来的内容中,我将深入探讨知识蒸馏框架及其底层架构和机制。

知识

知识蒸馏技术是深度学习中一项革命性的进步,它包括三个核心要素:知识、蒸馏算法和师生架构。

知识的多样性

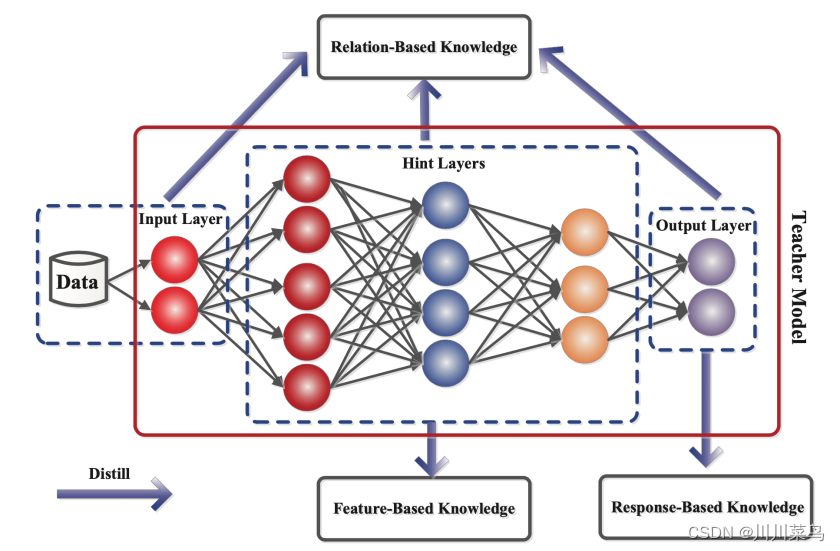

在神经网络领域,我们通常将“知识”定义为网络学习到的权重和偏差。在大型深度神经网络中,知识的来源异常丰富。例如,知识蒸馏中常用logits作为从教师模型提取知识的主要来源,但也有研究集中于利用中间层的权重或激活值。除此之外,其他知识形式还包括不同类型的激活、神经元间的关系,甚至是教师模型本身的参数。

我们可以将这些不同的知识形式归类为三种类型:

- 基于响应的知识(见图2)

- 基于特征的知识

- 基于关系的知识

下面,我将详细探讨这三种不同的知识来源及其在知识蒸馏中的应用。

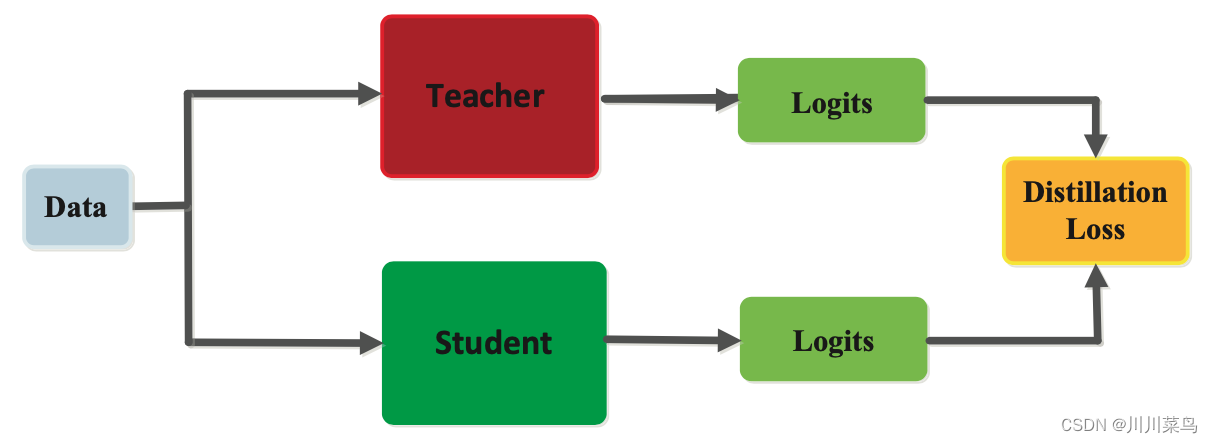

基于响应的知识

如图2所示,基于响应的知识主要关注教师模型的最终输出层。学生模型的目标是模仿教师模型的预测。这一过程,如图3所示,可以通过一种称为蒸馏损失的特殊损失函数来实现,该函数量化了学生模型与教师模型logits之间的差异。在训练过程中,通过最小化这一损失,学生模型逐渐学会像教师模型那样进行预测。

在计算机视觉任务(例如图像分类)中,软目标(soft targets)承载了基于响应的知识。软目标代表了输出类别的概率分布,通常通过softmax函数来估计。软目标在知识蒸馏过程中的影响通过一个称为“温度”的参数来调节,这种基于软目标的知识蒸馏通常应用于监督学习环境中。

基于特征的知识

如图4所示,经过训练的教师模型在其中间层中捕获了丰富的数据知识,这对深度神经网络至关重要。这些中间层学会识别特定的特征,这种知识可以被用来训练学生模型。目标是使学生模型学习到与教师模型相同的特征激活。通过最小化两者特征激活之间的差异,蒸馏损失函数实现了这一目标。

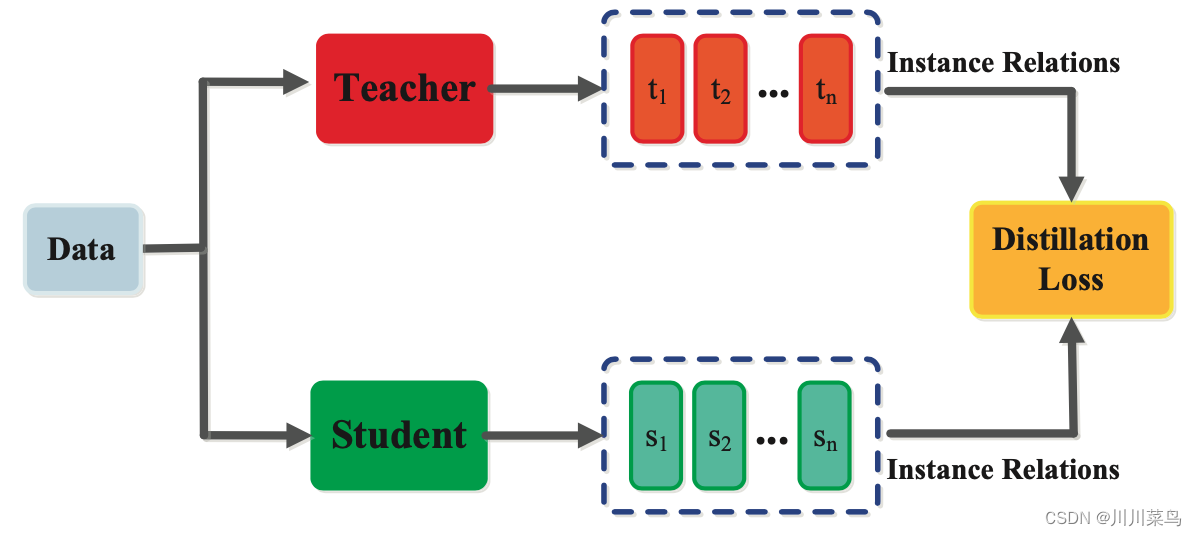

基于关系的知识

如图5所示,除了来自神经网络输出层和中间层的知识,我们还可以利用捕捉特征图之间关系的知识来训练学生模型。这种形式的知识,被称为基于关系的知识,可以通过模型特征图之间的相关性、图形、相似度矩阵、特征嵌入,或者特征表示的概率分布来建模。

通过深入理解这些知识的不同形式和来源,我们能更有效地实现知识蒸馏,从而在保持模型性能的同时减小其规模和复杂度。

训练

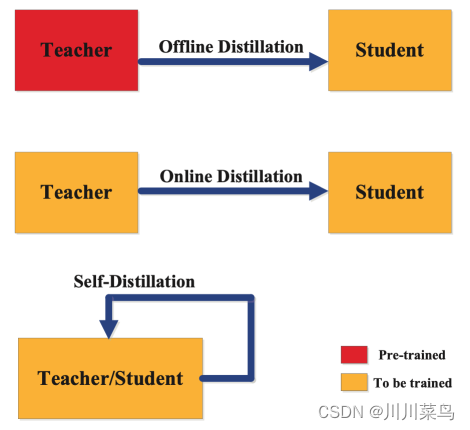

知识蒸馏的实施涉及多种训练方法,主要分为三种类型:离线蒸馏、在线蒸馏和自蒸馏。这些方法的选择取决于教师模型与学生模型是否同时进行修改,如图6所示。

离线蒸馏

离线蒸馏是最为常见的知识蒸馏方法。这种方法涉及使用一个已预训练的教师模型来指导学生模型。具体过程如下:首先在训练数据集上预训练教师模型,然后将教师模型的知识转移到学生模型中。鉴于深度学习领域的最新进展,现在有许多开源的预训练神经网络模型可用作教师。由于其实施相对简单,离线蒸馏在深度学习领域中成为了一种成熟的技术。

在线蒸馏

与离线蒸馏不同的是,在线蒸馏中,教师和学生模型在一个端到端的训练过程中同时进行更新。这种方法特别适用于无法使用预训练模型的场景。在线蒸馏可以充分利用并行计算资源,使其成为一种效率较高的训练方法。

自蒸馏

自蒸馏是一种独特的训练方法,如图6所展示,它使用同一模型作为教师和学生。例如,可以使用神经网络深层的知识来训练其浅层。这种方法可以被视为在线蒸馏的一个特例,并可以通过多种方式实现,例如将教师模型早期的知识传递给学生模型的后期训练。

通过这三种不同的训练方法,知识蒸馏技术为深度学习模型提供了灵活性和高效性,使其在现代计算环境中更具适应性和实用性。

架构设计的关键性

在知识蒸馏领域,设计高效的学生-教师网络架构至关重要。由于通常存在教师模型(复杂)与学生模型(简单)间的模型容量差距,优化知识传递变得尤为重要。以下是一些常见的架构设计方法:

- 简化版教师模型:使用更少的层和更少的神经元。

- 教师模型的量化版本:通过减少存储和计算需求来简化模型。

- 具有高效基本操作的较小网络:优化了运算效率。

- 具有优化全局网络架构的较小网络:更好地利用资源。

- 与教师相同的模型:但在某些方面进行了简化或优化。

此外,利用神经架构搜索这样的最新技术,可以为特定教师模型设计最优的学生模型架构。

知识蒸馏算法

本部分将深入探讨用于将教师模型的知识转移给学生模型的各种算法。

对抗蒸馏

在生成对抗网络(GAN)的背景下发展起来的对抗学习,已被应用于知识蒸馏。这种方法涉及训练一个生成模型,以生成尽可能接近真实数据分布的合成数据样本,以及一个判别器模型,用于区分真实和合成数据样本。对抗蒸馏利用这一概念,旨在提升学生和教师模型在真实数据分布表示方面的能力。

对抗学习可用于训练生成模型,以获取合成训练数据样本,这些样本可直接使用或用于增强原始训练数据集。基于对抗学习的另一种蒸馏方法关注于训练判别器模型,该模型根据逻辑或特征图区分学生和教师模型的输出。这有助于学生更好地模仿教师。此外,还有一种在线蒸馏技术,其中学生和教师模型同时进行优化。

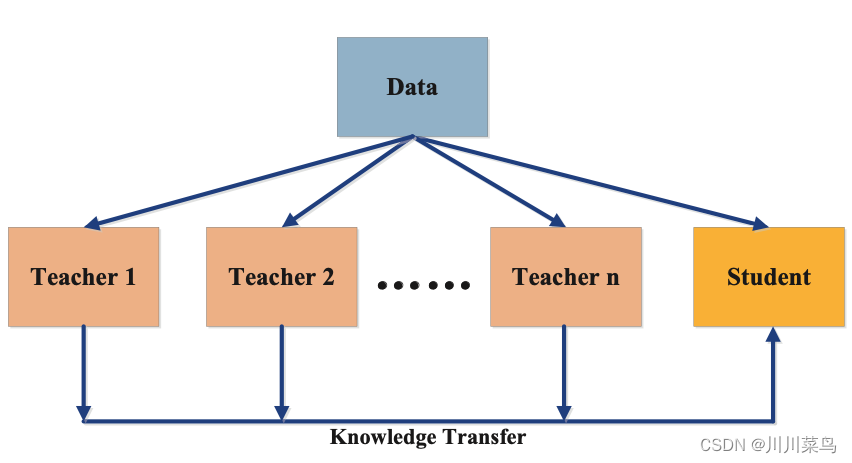

多教师蒸馏

多教师蒸馏策略下,学生模型从多个不同的教师模型获取知识。如图7所示,采用多个教师模型可以为学生模型提供多种类型的知识,这可能比单一教师模型提供的知识更有益。

多教师提供的知识可合并为所有模型的平均响应。通常,教师传递的知识类型基于逻辑和特征表示。正如之前讨论的,多个教师可以传递不同类型的知识。

跨模态蒸馏

跨模态蒸馏如图8所示,涉及一个在特定模态上训练的教师模型,其知识被提炼并传递到需要从不同模态获取知识的学生模型。当训练或测试期间缺乏特定模态的数据或标签时,跨模态蒸馏变得尤为重要。

这种方法在视觉领域尤为常见。例如,一个在带标签的图像数据上训练的教师模型的知识,可以用于提炼一个以无标签数据(如光流、文本或音频)为输入领域的学生模型。在这种情况下,教师模型的图像特征用于指导学生模型的训练。跨模态蒸馏对于视觉问答、图像描述等应用至关重要。

其他蒸馏算法

除了上述主要方法,还有几种其他蒸馏算法在知识蒸馏中有着重要应用:

- 基于图的蒸馏:使用图结构来捕捉数据内部的关系。

- 基于注意力的蒸馏:从特征嵌入中通过注意力图传递知识。

- 无数据蒸馏:在没有原始训练数据的情况下,使用合成数据进行训练。

- 量化蒸馏:从高精度教师模型传递知识到低精度学生模型。

- 终身蒸馏:将先前学到的知识积累并应用于未来的学习任务。

- 基于神经架构搜索的蒸馏:寻找最适合的学生模型架构以优化学习过程。

这些方法的多样性使得知识蒸馏成为一种强大而灵活的工具,能够适应各种深度学习的应用场景。

应用领域

知识蒸馏技术已成功应用于多个领域,包括图像识别、自然语言处理和语音识别。本节重点介绍其现有应用及未来潜力。

1. 视觉

在计算机视觉方面,知识蒸馏应用广泛,特别是在基于深度神经网络的先进视觉模型中。应用实例包括:

- 图像分类,

- 人脸识别,

- 图像分割,

- 动作识别,

- 物体检测,

- 车道检测,

- 行人检测,

- 面部特征点检测,

- 姿态估计,

- 视频字幕生成,

- 图像检索,

- 阴影检测,

- 文本到图像合成,

- 视频分类,

- 视觉问答等等 [3]。

此外,知识蒸馏还适用于特定应用场景,如跨分辨率人脸识别。通过结合高分辨率人脸(教师模型)和低分辨率人脸(学生模型)的架构,提高模型性能和降低延迟。由于能够利用包括跨模态数据、多领域、多任务和低分辨率数据在内的不同类型知识,知识蒸馏在特定视觉识别用例中展现出巨大潜力。

2. 自然语言处理(NLP)

在NLP领域,知识蒸馏尤为重要。考虑到大型深度神经网络(如GPT-3和BERT)的普及,其在语言模型和翻译模型中的应用尤为显著。例如,GPT-3拥有高达1750亿参数,远超BERT基础版本的1.1亿参数。

知识蒸馏在NLP中广泛使用,以获得更快、更轻量级的模型,降低训练和计算成本。其应用包括:

- 神经机器翻译

- 文本生成

- 问答系统

- 文档检索

- 文本识别

通过知识蒸馏,可以创建高效轻量级的NLP模型,降低内存和计算需求。学生-教师训练方法同样适用于多语言NLP问题,可实现不同语言模型间知识的转移和共享。

案例研究:DistilBERT

Hugging Face开发的DistilBERT是一种更小、更快、更轻量级的BERT模型。其预训练阶段应用了知识蒸馏,生成了尺寸减小40%(6600万参数)、速度提高60%(GLUE情感分析任务推理时间从668秒减至410秒),同时维持与原BERT模型相近准确率的蒸馏版本。DistilBERT采用了与BERT相同的架构,并结合了语言建模、蒸馏和余弦距离损失的创新三元损失函数。

3. 语音

先进的语音识别模型通常基于深度神经网络。现代自动语音识别(ASR)模型采用端到端训练,基于卷积层、带注意力机制的序列到序列模型和最新的Transformer架构。在实时、设备上的语音识别中,获取更小、更快的模型以提高效能至关重要。

语音领域的知识蒸馏用例包括:

- 语音识别,

- 口语语言识别,

- 音频分类,

- 说话人识别,

- 声学事件检测,

- 语音合成,

- 语音增强,

- 噪声鲁棒ASR,

- 多语言ASR,

- 口音检测 [10]。

案例研究:亚马逊Alexa的声学建模

Parthasarathi和Strom(2019)通过学生-教师训练方法,针对100万小时无标签语音数据生成了软目标,训练数据集包含7000小时标记语音。教师模型生成了所有输出类别的概率分布,学生模型根据相同的特征向量生成了相应的输出概率分布,优化了两个分布间的交叉熵损失。此方法简化了大量语音数据目标标签的生成过程。

结论

现代深度学习应用依赖于大型、占用大量内存且推理延迟长的神经网络。将这些模型部署到生产环境中是一大挑战。自2015年Hinton及其同事提出以来,知识蒸馏作为一种优雅的机制,用于训练小型、轻便、快速、经济的学生模型,已被广泛采纳并应用于生产场景,以获取高效轻量级模型。知识蒸馏是一种基于多种类型知识、训练方案、架构和算法的复杂技术,已在计算机视觉、自然语言处理、语音等多个领域取得巨大成功。

附录:我们的AI服务

第一款:与购买字节的API服务相仿,我们也供给正式的GPT中转API服务。然而,我们不会面临账户被封锁的问题,官方的封号行为不会导致项目的停顿。我们只提供稳定的服务,后台通过多种渠道来确保项目的持续稳定运行。此外,我们的价格还比官方网站更便宜。地址:https://api.zhangsan.cloud

第二款:提供官方镜像版本。你只需购买我们的授权码,我们会代理客户购买plus,客户只需在我们的官方镜像中填写授权码,就能享用与官网同样的插件、界面和联网功能等。地址:https://liao.zhangsan.cloud/login